Řízení rizik umělé inteligence pro bezpečnější budoucnost

Technologie založené na umělé inteligenci rychle pronikají do všech oblastí života: medicíny, vzdělávání, financí, sociálních médií, autonomních vozidel, programování atd. Pokrok nelze zastavit, takže vliv umělé inteligence se bude každým rokem jen rozšiřovat. V našem předchozím článku jsme se zabývali riziky umělé inteligence a nyní prozkoumáme, jak lze negativní faktory spojené s využíváním umělé inteligence omezit.

Nástroje pro detekci umělé inteligence

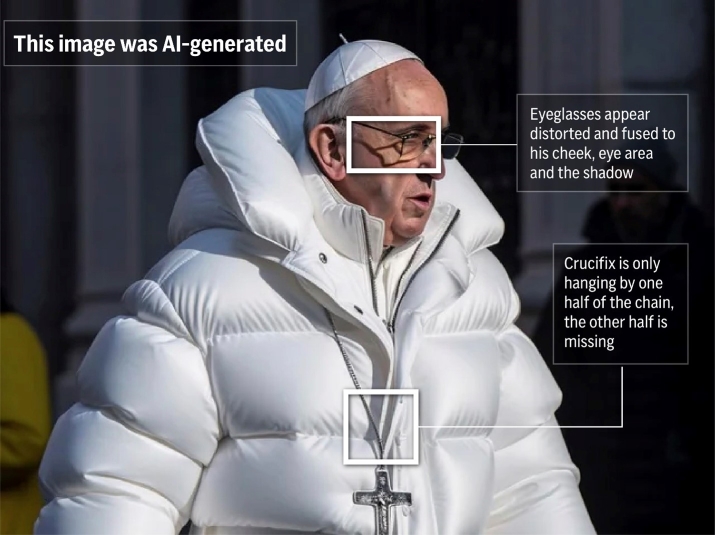

Pomocí moderních technologií je možné falšovat zvuky, fotografie a videa, vytvářet deepfakes, manipulovat s veřejným míněním, napodobovat cizí hlas a falšovat důkazy.

Vědci nyní pracují na způsobech, jak odhalit padělky, což jim umožní určit, zda byl zvukový nebo obrazový záznam pozměněn nebo zcela vytvořen umělou inteligencí.

Detekce vygenerovaných obrázků

- Společnost Intel vytvořila vůbec první platformu pro detekci falešných dat v reálném čase založenou na technologii FakeCatcher. Tato technologie využívá techniky dálkové fotopletysmografie k analýze jemného "krevního toku" v pixelech obrazu. Signály z několika snímků jsou zpracovávány pomocí klasifikátoru, který určí, zda je dané video skutečné, nebo falešné.

- Americká vládní agentura DARPA pracuje na technologiích SemaFor (zkratka pro Semantic Forensics), které dokáží přesně odhalit syntetické uměle vytvořené snímky.

Kromě toho již existují desítky různých nástrojů zaměřených na detekci generovaných obrázků a textů.

Kritické myšlení

Dezinformace, propaganda a různé metody klamání se objevily dávno před vynálezem umělé inteligence. Možná jste se vy nebo někdo z vašich známých stali terčem podvodníků. Někteří lidé se nechají snadno oklamat schématy, jako je e-mail s dědictvím "nigerijského prince", zatímco jiní jsou skeptičtější a uvažují kriticky. S rozvojem technologií, které dokážou manipulovat s obrázky, zvukem a videem, musíme nyní ještě pečlivěji ověřovat fakta.

Futurolog Mark Ford řekl: Ford Ford: "Nikdo neví, co je skutečné a co ne. Takže to skutečně vede k situaci, kdy doslova nemůžete věřit vlastním očím a uším; nemůžete se spolehnout na to, co jsme historicky považovali za nejlepší možné důkazy."

Boj proti podvodům a dezinformacím bude cyklickým procesem: jak se budou objevovat nové způsoby odhalování podvodů, ostatní budou vyvíjet způsoby, jak jim čelit, což povede k vytvoření ještě více ochranných opatření. Ačkoli nemusí poskytovat úplnou ochranu, nebudeme bezbranní.

Falešná fotografie papeže Františka

Vytváření nových pracovních míst

Rozsáhlé zavádění umělé inteligence s sebou nese riziko ztráty pracovních míst. Tento problém jsme podrobně rozebrali v jednom z předchozích článků. Tam také najdete odkazy na studie, zjistíte, které profese jsou nejvíce ohroženy a které ohroženy nejsou.

Samozřejmě, že mnoho lidí přijde kvůli umělé inteligenci o práci (podle různých odhadů od 100 do 800 milionů lidí) a někteří budou muset projít profesní rekvalifikací (Seo.ai odhaduje jejich počet na 120 milionů lidí).

Umělá inteligence však nebude pouze ubírat pracovní místa, ale také vytvářet nová. Navíc je možný scénář, kdy nová pracovní místa vznikají rychleji, než ta stará zanikají. Zde je to, co o tom píše Světové ekonomické fórum:

Přestože počet zrušených pracovních míst bude překonán počtem vytvořených "pracovních míst zítřka", na rozdíl od předchozích let se tvorba pracovních míst zpomaluje, zatímco jejich rušení se zrychluje. Na základě těchto údajů odhadujeme, že do roku 2025 může být v důsledku změny dělby práce mezi lidmi a stroji nahrazeno 85 milionů pracovních míst, zatímco může vzniknout 97 milionů nových rolí.

Mezi nově vznikající pracovní místa patří:

- Inženýři modelů a promptů umělé inteligence

- Návrháři rozhraní a interakcí

- Tvůrci obsahu s umělou inteligencí

- Kurátoři a školitelé dat

- Specialisté na etiku a správu

Některá nová pracovní místa

Přijetí technologie

Někteří učitelé se obávají, že žáci nebudou rozvíjet své dovednosti psaní, protože práci za ně udělá umělá inteligence. Podobná situace byla v 70. a 80. letech 20. století, kdy se rozšířily elektronické kalkulačky. Učitelé matematiky se obávali, že se žáci přestanou učit základní aritmetiku.

Vždycky existovali odpůrci pokroku. Před tisíci lety, ve starověkém Řecku, se Sokrates vyslovil proti samotnému psaní:

[Psaní] vyvolá v duších žáků zapomnění, protože nebudou používat svou paměť; budou důvěřovat vnějším psaným znakům a nebudou si pamatovat sami sebe. Specifikum, které jste objevili, není pomůckou pro paměť, ale pro vzpomínání, a svým žákům nedáte pravdu, ale jen zdání pravdy; budou posluchači mnoha věcí a nic se nenaučí; budou se tvářit jako vševědoucí a většinou nebudou vědět nic; budou únavnou společností, budou mít zdání moudrosti bez skutečnosti.

Nejsem tak starý, abych si pamatoval starověké Řecko, ale můj učitel matematiky říkával: "Ne vždycky budeš mít v kapse kalkulačku." A hádejte co? Kalkulačku v kapse mám. Je to aplikace v mém telefonu.

Pokrok nelze zastavit. Dříve nebo později budou lidé muset přijmout technologie založené na umělé inteligenci. Umělá inteligence se stane stejně běžným nástrojem jako kalkulačka.

MathGPT Pro

V tuto chvíli je třeba si uvědomit, že chatboti jsou nedokonalí, náchylní k halucinacím a je třeba pečlivě kontrolovat přesnost generovaných informací. Práce se zdroji a dvojitá kontrola faktů je však ve vzdělávací nebo výzkumné práci běžná. A postupem času se chatboti budou zlepšovat a stávat se spolehlivějšími - můžeme to vidět na vývoji ChatGPT, od GPT-2 po GPT-4.

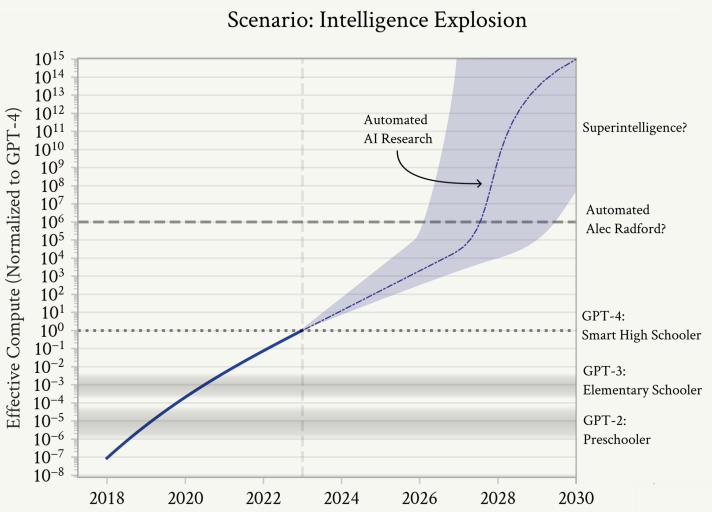

Škálovatelný dohled

Jak se systémy umělé inteligence stávají výkonnějšími a složitějšími, je stále náročnější je kontrolovat prostřednictvím lidské zpětné vazby. Vyhodnocování složitého chování UI může být pro člověka pomalé nebo neproveditelné, zejména pokud UI v dané oblasti předčí člověka. Aby člověk odhalil, kdy je výstup UI falešně přesvědčivý, potřebuje pomoc nebo rozsáhlý čas. Škálovatelný dohled může snížit čas a úsilí potřebné pro dohled.

Podle Nicka Bostroma by vývoj superinteligence mohl potenciálně zmírnit existenční rizika, která představují jiné pokročilé technologie, jako jsou molekulární nanotechnologie nebo syntetická biologie. Upřednostnění vytváření superinteligence před jinými potenciálně nebezpečnými technologiemi by tedy mohlo snížit celkové existenční riziko.

Vývoj superinteligence pro dohled nad běžnou umělou inteligencí se může zdát jako předbíhání vozu před koněm, ale superinteligence nemusí být daleko. Podle článku "Situational Awareness" od Leopolda Aschenbrennera bychom se superinteligence mohli dočkat do 10 let.

Exploze umělé inteligence

Než bychom se nadáli, měli bychom v rukou superinteligenci - systémy umělé inteligence mnohem chytřejší než lidé, schopné nového, kreativního a komplikovaného chování, kterému ani nedokážeme porozumět - možná i malou civilizaci miliard takových systémů. Jejich síla by byla také obrovská. Při použití superinteligence ve výzkumu a vývoji v jiných oblastech by se explozivní pokrok rozšířil z pouhého výzkumu strojového učení; brzy by vyřešily robotiku, během několika let by udělaly dramatický skok v dalších oblastech vědy a techniky a následovala by průmyslová exploze. Superinteligence by pravděpodobně poskytla rozhodující vojenskou výhodu a rozvinula by nevýslovné ničivé síly. Čekal by nás jeden z nejintenzivnějších a nejvypjatějších okamžiků lidských dějin.