Tekoälyn riskien hallinta turvallisemman tulevaisuuden takaamiseksi

Tekoälyyn perustuvat teknologiat valtaavat nopeasti alaa kaikilla elämän osa-alueilla: lääketieteessä, koulutuksessa, taloudessa, sosiaalisessa mediassa, autonomisissa ajoneuvoissa, ohjelmoinnissa jne. Kehitystä ei voi pysäyttää, joten tekoälyn vaikutus vain laajenee vuosi vuodelta. Edellisessä artikkelissamme tarkastelimme tekoälyn riskejä, ja nyt tutkimme, miten tekoälyn käyttöön liittyviä kielteisiä tekijöitä voidaan vähentää.

Tekoälyn havaitsemisvälineet

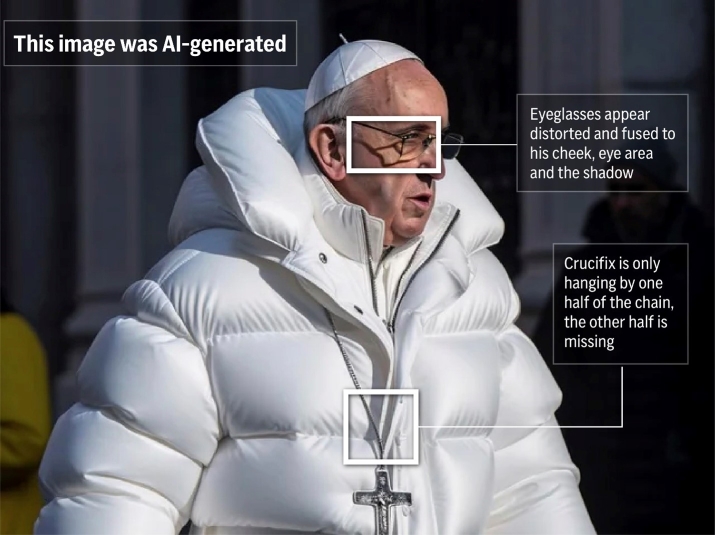

Nykyteknologian avulla on mahdollista väärentää ääntä, valokuvia ja videoita, luoda deepfake-tekstejä, manipuloida yleistä mielipidettä, jäljitellä toisen henkilön ääntä ja väärentää todisteita.

Tutkijat työskentelevät nyt keinojen parissa, joilla väärennökset voidaan havaita ja joiden avulla voidaan määrittää, onko ääni- tai videotallenne muokattu tai kokonaan tekoälyn tuottama.

Tuotettujen kuvien havaitseminen

- Intel loi ensimmäisen reaaliaikaisen deepfake-tunnistusalustan, joka perustuu FakeCatcher-teknologiaan. Teknologia käyttää etävalopletysmografiatekniikoita analysoidakseen kuvan pikseleissä olevaa hienovaraista "verenkiertoa". Useiden kuvien signaalit käsitellään luokittelijan kautta, jotta voidaan määrittää, onko kyseinen video aito vai väärennös.

- Yhdysvaltain hallituksen virasto DARPA työskentelee SemaFor-tekniikoiden parissa (lyhenne sanoista Semantic Forensics), joilla voidaan tarkasti havaita synteettiset keinotekoisesti luodut kuvat.

Lisäksi on jo olemassa kymmeniä erilaisia työkaluja, joiden tarkoituksena on tunnistaa luotuja kuvia ja tekstiä.

Kriittinen ajattelu

Harhaanjohtaminen, propaganda ja erilaiset petosmenetelmät ovat olleet olemassa jo kauan ennen tekoälyn keksimistä. Ehkä sinä tai joku tuttavasi on joutunut huijareiden kohteeksi. Joitakin ihmisiä on helppo huijata "nigerialaisen prinssin" perintösähköpostin kaltaisilla juonilla, kun taas toiset ovat skeptisempiä ja ajattelevat kriittisesti. Kuvia, ääntä ja videoita manipuloivan teknologian yleistyttyä meidän on nyt oltava entistäkin huolellisempia faktojen tarkistamisessa.

Futuristi Mark Ford sanoi: "Kukaan ei tiedä, mikä on todellista ja mikä ei. Se johtaa tilanteeseen, jossa ei voi kirjaimellisesti uskoa omia silmiään ja korviaan, eikä voi luottaa siihen, mitä historiallisesti olemme pitäneet parhaana mahdollisena todisteena."

Huijausten ja väärän tiedon torjuminen on syklinen prosessi: kun uusia keinoja petoksen havaitsemiseksi ilmaantuu, muut kehittävät keinoja niiden torjumiseksi, mikä johtaa entistä useampien suojatoimien luomiseen. Vaikka se ei ehkä tarjoa täydellistä suojaa, emme ole puolustuskyvyttömiä.

Väärennetty kuva paavi Franciscuksesta

Uusien työpaikkojen luominen

Tekoälyn laajamittaiseen käyttöönottoon liittyy työpaikkojen menetyksen riski. Käsittelimme tätä ongelmaa yksityiskohtaisesti yhdessä aiemmista artikkeleista. Sieltä löydät myös linkkejä tutkimuksiin ja saat selville, mitkä ammatit ovat suurimmassa vaarassa ja mitkä eivät ole vaarassa.

Tietenkin monet ihmiset menettävät työnsä tekoälyn takia (eri arvioiden mukaan 100-800 miljoonaa ihmistä), ja jotkut joutuvat käymään ammatillisen uudelleenkoulutuksen (Seo.ai arvioi heidän määräkseen 120 miljoonaa ihmistä).

Tekoäly ei kuitenkaan ainoastaan vie työpaikkoja, vaan myös luo uusia. Lisäksi on mahdollista, että uusia työpaikkoja syntyy nopeammin kuin vanhoja katoaa. Näin kirjoittaa asiasta Maailman talousfoorumi:

Vaikka luotujen "tulevaisuuden työpaikkojen" määrä ylittää tuhoutuneiden työpaikkojen määrän, toisin kuin aiempina vuosina, työpaikkojen luominen hidastuu samalla kun työpaikkojen tuhoutuminen kiihtyy. Näiden lukujen perusteella arvioimme, että vuoteen 2025 mennessä 85 miljoonaa työpaikkaa voi hävitä ihmisten ja koneiden välisen työnjaon muuttumisen vuoksi, kun taas 97 miljoonaa uutta tehtävää voi syntyä.

Uusia työpaikkoja syntyy muun muassa seuraavilla aloilla:

- Tekoälymalli- ja kehoteinsinöörit

- Käyttöliittymä- ja vuorovaikutussuunnittelijat

- Tekoälyllisen sisällön luojat

- Datan kuraattorit ja kouluttajat

- Etiikan ja hallinnon asiantuntijat

Osa uusista työpaikoista

Teknologian omaksuminen

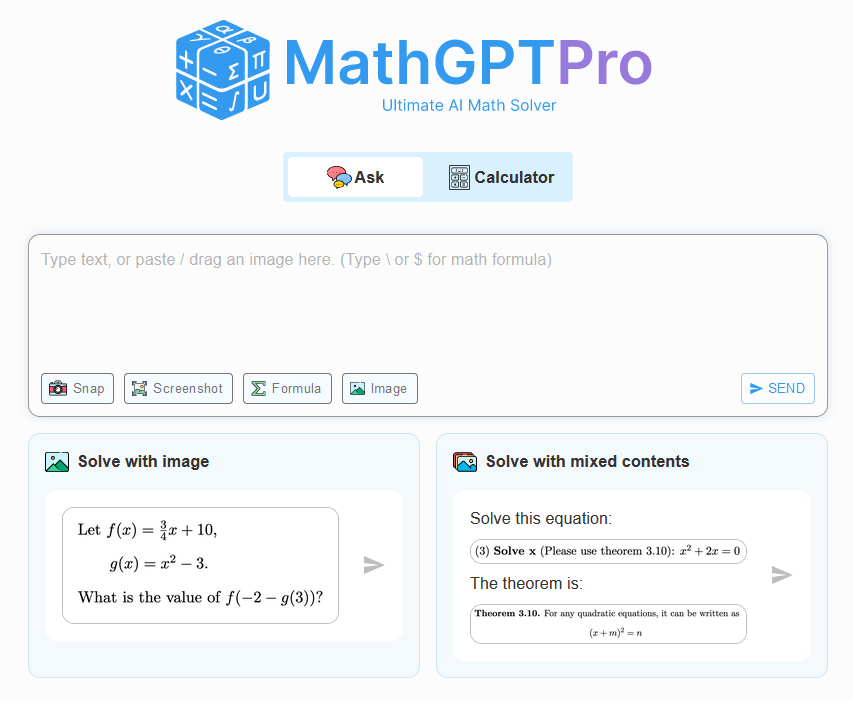

Jotkut opettajat ovat huolissaan siitä, että oppilaat eivät ehkä kehitä kirjoitustaitojaan, koska tekoäly tekee työn heidän puolestaan. Samanlainen tilanne oli 1970- ja 1980-luvuilla, kun elektroniset laskimet yleistyivät. Matematiikan opettajat pelkäsivät, että oppilaat eivät enää oppisi peruslaskutoimituksia.

Kehityksen vastustajia on aina ollut. Tuhansia vuosia sitten muinaisessa Kreikassa Sokrates puhui itse kirjoittamista vastaan:

[Kirjoittaminen] aiheuttaa oppijoiden sieluissa unohduksen, koska he eivät käytä muistiaan; he luottavat ulkoisiin kirjoitettuihin merkkeihin eivätkä muista itseään. Erityinen, jonka olette keksineet, ei ole muistin apuväline vaan muistamisen apuväline, ja te ette anna oppilaillenne totuutta vaan ainoastaan totuuden näennäisyyttä; he ovat monien asioiden kuulijoita eivätkä ole oppineet mitään; he näyttävät kaikkitietäviltä eivätkä yleensä tiedä mitään; he ovat rasittavaa seuraa, koska heillä on viisauden näennäisyyttä ilman todellisuutta.

En ole niin vanha, että muistaisin muinaisen Kreikan, mutta matematiikan opettajallani oli tapana sanoa: "Taskussasi ei aina ole laskinta." Ja arvaa mitä? Minulla on taskussa laskin. Se on sovellus puhelimessani.

Kehitystä ei voi pysäyttää. Ennemmin tai myöhemmin ihmisten on omaksuttava tekoälyyn perustuvat teknologiat. Tekoälystä tulee yhtä yleinen työkalu kuin laskimesta.

MathGPT Pro

Tässä vaiheessa on muistettava, että chatbotit ovat epätäydellisiä ja alttiita hallusinaatioille, ja tuotettujen tietojen oikeellisuus on tarkistettava huolellisesti. Lähteiden kanssa työskentely ja faktojen tarkistaminen kahdesti on kuitenkin arkipäivää opetus- tai tutkimustyössä. Ja ajan myötä chatbotit tulevat paremmiksi ja luotettavammiksi - voimme nähdä tämän ChatGPT:n kehityksessä GPT-2:sta GPT-4:ään.

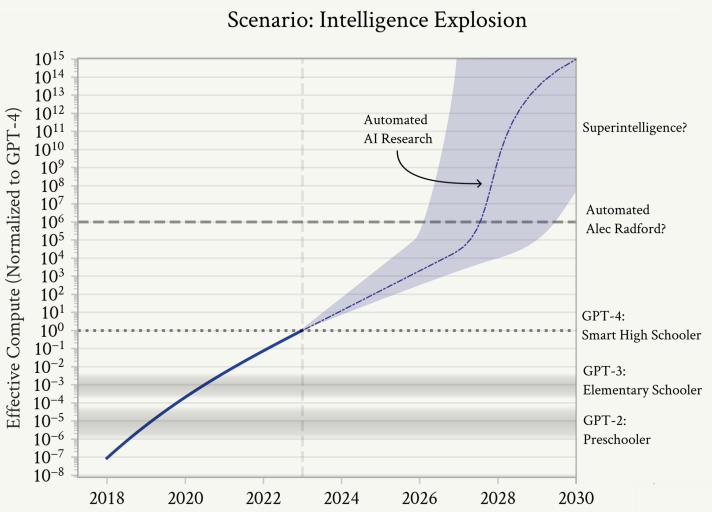

Skaalautuva valvonta

Kun tekoälyjärjestelmistä tulee yhä tehokkaampia ja monimutkaisempia, niiden valvominen ihmisen antaman palautteen avulla on yhä haastavampaa. Ihmisten voi olla hidasta tai mahdotonta arvioida monimutkaista tekoälyn käyttäytymistä, varsinkin kun tekoäly on ihmistä parempi tietyllä alalla. Ihminen tarvitsee apua tai paljon aikaa havaitakseen, milloin tekoälyn tuotos on virheellisesti vakuuttava. Skaalautuva valvonta voi vähentää valvontaan tarvittavaa aikaa ja vaivaa.

Nick Bostromin mukaan superälykkyyden kehittyminen voisi mahdollisesti lieventää muiden kehittyneiden teknologioiden, kuten molekulaarisen nanoteknologian tai synteettisen biologian, aiheuttamia eksistentiaalisia riskejä. Näin ollen superälykkyyden luomisen priorisointi ennen muita mahdollisesti vaarallisia teknologioita voisi pienentää yleistä eksistentiaalista riskiä.

Superälykkyyden kehittäminen tavallista tekoälyä valvomaan saattaa tuntua siltä, että se on kärryjen ajo hevosen edelle, mutta superäly ei ehkä ole kaukana. Leopold Aschenbrennerin "Situational Awareness" -kirjan mukaan superälyä voidaan nähdä jo 10 vuoden kuluttua.

Tekoälyn räjähdysmäinen kasvu

Ennen kuin huomaammekaan, meillä olisi käsissämme superälykkyys - tekoälyjärjestelmiä, jotka olisivat huomattavasti ihmistä älykkäämpiä ja kykenisivät uudenlaiseen, luovaan ja monimutkaiseen käyttäytymiseen, jota emme pystyisi edes ymmärtämään - ehkä jopa miljardien ihmisten muodostama pieni sivilisaatio. Niiden valta olisi myös valtava. Soveltamalla superälyä muiden alojen tutkimukseen ja kehitykseen räjähdysmäinen edistys laajentuisi pelkän koneoppimisen tutkimuksesta; pian ne ratkaisisivat robotiikan, tekisivät dramaattisia harppauksia muilla tieteen ja teknologian aloilla vuosien kuluessa, ja sitä seuraisi teollinen räjähdys. Superälykkyys tarjoaisi todennäköisesti ratkaisevan sotilaallisen edun ja avaisi mittaamattomat tuhovoimat. Edessämme olisi yksi ihmiskunnan historian kiihkeimmistä ja epävakaimmista hetkistä.